로컬 LLM 모델 사용을 위한 LM Studio 설치 및 사용 방법

LM Studio는 로컬 컴퓨터에서 대규모 언어 모델(LLM)을 쉽게 찾아서 다운로드하고 사용할 수 있도록 해주는 프로그램이다.

구글의 젬마(gemma)나 메타의 라마(lama), 최근 유명했던 딥시크 등을 설치하고 사용이 가능한데 무료로 사용가능하다는 부분이나 인터넷 연결 없이 사용 가능하다는 장점 등이 있어 상황에 따라서 상당히 유용하게 사용이 가능하다.

LM Studio 설치 및 사용 방법

1. 설치 파일 다운로드.

아래의 링크를 클릭하여 사이트에 접속한 뒤 설치 파일을 다운로드하자.

LM Studio - Discover, download, and run local LLMs

2. 설치.

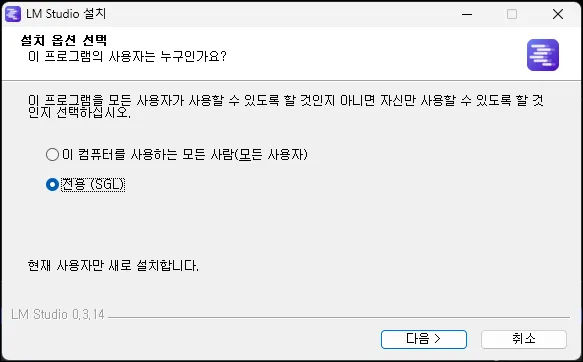

파일을 실행하면 설치를 할 수 있다.

설치 과정은 특별한 부분이 없으며 [다음]을 클릭하면 알아서 진행된다.

3. LLM 모델 설치.

3-1. 처음 실행하면 LLM 모델을 추천하는 화면이 나타나는데 일단 오른쪽 상단의 버튼을 클릭하여 넘어가자.

3-2. LM Studio 왼쪽 메뉴에서 [돋보기 모양 아이콘]을 클릭.

3-3. 모델을 설치할 수 있는 창이 나타나면 원하는 모델을 찾아 클릭하고 [Download] 버튼을 클릭하고 설치를 기다리면 된다.

(검색을 하면 더 많은 모델이 나타나니 원하는 모델이 없다면 검색을 해보자.)

참고로 같은 모델이라도 뒤에 붙은 명칭에 따라 차이점이 있는데 구글의 모델 Gemma를 기준으로 간단히 설명하자면 아래와 같다.

| Gemma 3 4B QAT Gemma : LLM 모델명. 3 : 버전. 4B : 파라미터 수, 숫자가 높을수록 고성능이며 그만큼 많은 자원을 사용. QAT : 양자화 인식 학습(Quantization Aware Training), 자원사용량을 낮춰 성능을 향상시킨 버전. 최대한 성능을 유지하면서 효율을 중시한 버전이라고 볼 수 있다. |

4. 설치한 모델 사용.

모델의 설치를 완료했다면 [Load Model]을 클릭하고 채팅을 하면 된다.

모델을 여러 개 설치했다면 LM Studio 상단 부분에서 모델을 변경하여 채팅할 수도 있다.

그 외 내용

- LM Studio의 오른쪽 하단을 보면 현재 램과 CPU 사용량을 확인할 수 있다.

답변에 너무 과도한 자원을 사용한다면 MY Model에서 설치한 모델의 GPU와 GPU의 사용량을 변경할 수 있으니 확인해 보자.

(GPU 부분을 0으로 변경하면 속도가 느려지긴 하지만 CPU만 사용해서 답변을 한다)

- Developer에서는 로컬 서버를 실행하고 다른 애플리케이션에서 접근할 수 있도록 할 수 있다.

단순하게 예를 들면 이를 활용하여 파이썬으로 실행 중인 로컬 서버에 질문을 보내고 답변을 받아올 수 있는 프로그램을 만들 수 있게 된다는 것.

- 영어로 되어있는 것이 불편하다면 오른쪽 하단의 톱니바퀴를 클릭하여 설정 창을 열고 언어를 변경하자.

아직 beta 버전이라 완벽하지는 않지만 불편하지 않은 선에서 한글로 사용하는 것이 가능해진다.

- LM Studio를 종료하기 위해 [X]를 눌러도 트레이를 보면 남아있다.

트레이에서 마우스 우클릭 메뉴를 열고 종료해야 완전히 종료 된다.